Цель материала – не разобрать все, что только возможно по теме ядра и запросов/ключевых слов/фраз, а дать практическую информацию с минимальным отхождением от вопроса. А охват вопроса широкий, получится рассказать на полноценную книгу в десятки страниц. Да и здесь обширный список вопросов разжеван – статья очень большая, но изучение стоит того, я искренне верю, что это лучшее практическое руководство в интернете (провел предварительный анализ существующих в сети материалов).

Далее подробно рассмотрю конкретную основу и полезные тонкие моменты, которые помогают своими руками провести семантическую аналитику тематики. А также в полной мере самостоятельно сделать подбор запросов без ошибок, отказавшись от использования платных услуг специалистов, работа которых может стоить не так дешево, да и не факт, что составят качественно. Тем, кто воспользуется услугами, мануал все-таки сможет помочь максимально разобраться в теме и понять, правильно ли действует исполнитель, и отличить грамотных «семантистов» от халтурщиков.

Я мог бы написать вам про виды запросов (геозависимые, транзакционные, коммерческие, низкочастотные, высокочастотные, брендовые и тому подобное), но зачем? Для общего образования почитайте информацию в интернете, но от таких знаний ваши навыки не улучшатся, семантика круче не станет. Я, например, теорию не то, что не знаю, а никогда не использовал на практике. Так зачем буду ее давать…. Уверен, что и вам она не сильно пригодится, за исключением нескольких определений. Главное – понимать сам принцип составления.

- Что такое семантическое ядро сайта

- Примеры семантического ядра

- Необходимость и задачи семантики

- Куда вставлять семантическое ядро

- Что важно знать перед составлением

- Как можно создавать ядра

- Можно ли собрать бесплатно

- Можно ли создать полностью автоматически

- Из каких этапов состоит сбор

- Про кластеризацию поисковых запросов

- Как составить семантическое ядро на реальном примере

- Что потребуется при составлении

- Важный нюанс по аккаунтам и прокси

- Волшебная пилюля – нет прокси и аккаунтам

- Обязателен ли Key Collector

- Базовая настройка Key Collector для парсинга

- Какую тематику выбрал

- Сбор входных слов

- Добавление баз в проект KC

- Первый прогон фраз

- Повторный парсинг в глубину

- Чистка ядра

- Кластеризация

- Пару слов о планировщике

- Что на выходе

- Подбор ядра онлайн на основе конкурентов

- Разница в составлении между типами сайтов

- FAQ – ответы на частые вопросы

- Личное обучение составлению семантического ядра

- Заказать семантику: дорого, но качественно

- Эпилог

Что такое семантическое ядро

На вид это простой список запросов ниши (тематики) сайта, которые пользователи вбивают в поисковые системы, чтобы решить свою проблему. Некоторые ищут инструкции, как починить пылесос, узнать про существующие виды переломов костей, а кто-то хочет выбрать обои, купить двухдверный холодильник, заказать стяжку пола, установку антенны, изготовление кухни и так далее.

В зависимости от тематики сайта (например, пылесосы, Телеграм, заработок в интернете, поделки, бытовая техника, двери, электрические котлы и другие) количество запросов может существенно отличаться.

Как выглядит готовая семантика (примеры)

Выложу нескольких примеров грамотно собранных ядер для статейных сайтов и онлайн-магазинов в Google Таблицы.

Некоторые группы выложены в неполном объеме, так как содержат сотни фраз. Главное – заиметь четкое представление, что должно получиться на выходе после составления и группировки ядра.

Посмотрите скриншоты примеров готовых качественных групп под конкретные страницы для информационных проектов.

Группа ключей для статьи про комнатные антенны

Группа для статьи про ошибку принтера

Группа запросов для статьи о заклеивании линолеума

Группа игровой тематики

Группа для сайта по слаймам

Группа для медицинского сайта

Примеры для магазинов. Закину, как только доберусь до третьего ноутбука, поэтому добавьте страницу в закладки и периодически заглядывайте.

В комплексе набор таких групп для всей тематики и формируют ядро.

Зачем нужна семантика сайту

- Имея на руках максимально полный список, можно в какой-то степени прогнозировать будущий трафик на документ из поисковика и создавать в первую очередь только эффективные по сделанному прогнозу страницы, дающие максимально большой, быстрый результат как по посещеаемости, так и по деньгам. Например, собрал группу под страницу с суммарной частотностью показов 9000 в месяц. Сразу понимаю, что в сутки все запросы по теме страницы люди вбивают в поисковую строку Яндекса 300 раз. То есть, если выбиться в ТОП 1-3 Яндекс, то по расчету могу получать около 300 чел/сутки на стр. Но с существенной поправкой – никогда весь трафик даже первая позиция не забирает, поэтому смело цифру можно делить на 3, т. е. ориентировочно можно рассчитывать на 100 посетителей/день.

- Для качественной проработки страницы. Упуская даже мелкие запросы, которые мало запрашивают люди, мы теряем охват контента, а значит сужаем раскрытие темы и не «добиваем» оптимизацию. Как следствие, трафика меньше, конкурентов обходить сложнее.

- Для максимальной оптимизации страницы и самого текста. Да да, оптимизируется не только текстовый блок. Есть и другие элементы страницы, которые при наличии опыта и знаний можно оптимизировать без вреда для сайта. Сюда конечно же входят общеизвестные понятия – Title, H1-Н6, description. Но есть такие вещи, как теги (метки), другие активные элементы (например, ссылки в похожих записях, внутренняя перелинковка, опросы, фильтры, хлебные крошки, ссылки в меню), за счет которых в ТОП выдачи твердо сидят сайты-агрегаторы, на которых вообще нет SEO текстов, а только лишь оптимизация активных элементов. На инфосайтах их тоже можно использовать, гиганты, впрочем, так и делают (видимо они что-то знают). Для интернет-магазинов оптимизировать тексты в последнее время вообще опасно, поэтому ключи в приоритете зашиваются сразу для одной или нескольких категорий, или даже целого сайта, в шаблон, из-за чего все страницы разом становятся более релевантными запросу, так как нужные слова и фразы есть вне зоны текста.

- Для внешнего продвижения (ссылочного). Покупать ссылки для сайта также требуется на основе фраз, которые следует продвигать. И чем обширнее выйдет семантика, тем более безопасно и точечно получится бить по всему пулу запросов. Аналогично с внутренними ссылками в рамках проекта – перелинковкой.

- Для составления структуры сайта (разделов и подразделов) еще перед или во время разработки сайта, чтобы дать точное задание верстальщику, дизайнеру, программисту. На практике почти все вебмастера создают разделы на основе конкурентов, что вполне нормально, но более эффективно совместить семантику с анализом конкурентов. Так получится распределить материалы по разделами максимально понятно, чтобы в каждой категории/подкатегории были только целевые страницы. Имея на руках полностью составленное ядро, параллельно с проектированием структуры, получится оптимизировать навигационные элементы каждого раздела, чтобы кроме блока текста ключи были вписаны и в ссылки навигации.

Объяснение последнего пункта на примере информационной ниши «Офисная техника».

В рамках сайта есть направление «Принтеры». Практически все конкуренты поголовно размещали статьи по теме «сброс счетчиков» в общем разделе «Обслуживание», где также рассматривались темы «чистки принтеров и печатающих головок».

Спарсив запросы и сделав кластеризацию, я увидел, что по каждому вопросу есть минимум по 10-15 страниц – пользователи запрашивают как общие темы, так и по конкретной модели принтера. Поэтому было принято решение создать общий раздел «Обслуживание», а внутри подраздели: «Чистка принтеров» и «Сброс счетчиков».

Таким образом у меня автоматически в хлебных крошках появились отдельные слова и вырванные части полноценных фраз из семантических кластеров. Дополнительно использовал другие нарезки фраз в сквозном главном меню, чтобы расширить охват разных конструкций из семантики, не повторяясь. Как следствие, на каждой странице автоматически стали выводиться важные слова, которые охватывали целые разделы.

Если в начале, еще до построения структуры, не прорабатывалось ядро, то разделы, скорее всего, создавались бы по аналогии с конкурентами, что не так плохо, но и не является лучшим вариантом для SEO. Реализацию на личном блоге смотрите чуть ниже на скриншоте.

А вот для коммерции структура крайне важна и прорабатывается до самых мелочей.

Также на основе запросов создают объявления контекстной рекламы (Яндекс Директ, Google Adwords) для бизнеса (продажи услуг, товаров, продукктов), чтобы привлекать только целевых клиентов для максимальной конверсии и достижения минимальной цены клика в рекламной сети.

Используется не только для SEO, но и маркетинга в целом, чтобы выявить спрос аудитории.

Как использовать семантическое ядро (куда вставлять)

На любом проекте ключевые фразы употребляются в SEO-заголовке (Title), мета-описании для поиска (Description) и заголовке для зашедшего посетителя (H1). Дополнительно можно зашивать слова в подзаголовки (H2-H6, практически никогда дальше Н4 не заходил).

Места вставки на информационных ресурсах:

- текст;

- подзаголовки;

- хлебные крошки;

- ссылки в главном меню и рубриках (если блок дополнительно выводится в сайдбаре- боковой колонке);

- ссылки внутри статьи (содержание/оглавление, в перелинковке на другие материалы, похожие записи, ссылки-кнопки);

- теги Alt изображений.

Наглядный пример реализации сделан на моем блоге.

Основной областью всегда является статья, но остальные части документа также учитываются.

Места употребления семантики на коммерческих ресурсах (в добавок к предыдущему списку);

- фильтры выбора моделей товаров, марок, размеров, цветов, мощности и т. д.;

- сортировки (по рейтингу, по популярности, по стоимости, от дорогих к дешевым и т. д.);

- плитки тегов перед листингом товаров;

- названия в ассортименте товаров на странице категорий.

- похожие товары.

Некоторые важные определения (термины) для работы с семантикой

- Ключевая фраза (запрос, ключ, поисковая фраза) – одиночные слова или многословные фразы, которые человек пишет в строке поиска любой системы (Яндекс, Google, Mail, Yahoo и т. д.). На самом деле, разница все-таки есть в употреблении – ключевая фраза и поисковая имеют разное происхождение. Первое относится к употреблению на сайте, а второе касается поисковой системы, то есть то, что человек запрашивает в сети.

- Парсинг – процесс сбора любых данных: фраз, числовых значений (частотностей, конкуренции, цена клика в Яндекс Директ и т. д.) и других показателей.

- Запрос маска – базовый (основной) однословный (реже двухсловный) общий запрос без дополнительных слов, который образует общую тему сайта или раздела. Например: «фундамент», «краска», «обои», «полка», «тумба», «гипскокартон».

- Запрос маркер (или маркерный запрос) – уточнение для основного, что увеличивает понимание намерения человека. Например: «обои рейки», «книжная полка», «подвесная тумба», «виды фундаментов», «краска feidal magie», «гипсокартон влагостойкий». Для инфосайтов отличными маркерами при парсинге будут вопросительные слова «как, почему, что, зачем, где, сколько, для чего».

- Хвост запроса – дополнительные слова-уточнения для маркерного. Например: «обои рейки фото», «книжная полка лофт», «подвесная тумба под телевизор», «виды фундаментов для дома», «краска feidal magie нанесение», «гипсокартон влагостойкий нужно ли защищать от влаги». Хвосты могут состоять из несколько слов и, чем больше их больше, тем более низкочастотный и низкоконкурентный запрос. На западе называются Long-tail-запросами. Дают больше понимания, что хочет пользователь.

- Кластеризация (группировка) – процесс распределения запросов из общего списка по отдельным группам, чтобы страница в плане SEO соответствовала одной проблеме, намерению (интенту) пользователя, но охватывала полный семантический спектр, а не один ключ. Реальные примеры выкладывал в начале руководства.

Методы сбора ключевых запросов для страниц сайта

Кластеры, в зависимости от поставленной задачи, можно собрать комплексно сразу для целого проекта, или какой-то части, например, одного или нескольких разделов/направлений. Или же составлять постранично, чтобы отрабатывать страницу за страницей.

Можно вытягивать данные с публичного сервиса Wordstat от Яндекс и дополнять базами, или ограничиться только последними. В большинстве случаев применяется Key Collector, но есть варианты и онлайн сбора.

Можно ли собрать бесплатно

Все веб-мастера и семантисты знают о бесплатном источнике анализа ключевых слов «Вордстат» от Яндекс (https://wordstat.yandex.ru/). Если использовать расширение для браузера Yandex Wordstat Assistant, то можно легко вручную скопировать необходимые фразы и вставить для дальнейшей обработки.

Зайдите в Wordstat, вбейте в поле нужный ключ. Обращайте внимание как на левую (основную), так и на правую колонку (эхо), где указываются синонимы и тематические слова/фразы. Нажимайте на плюс напротив необходимых фраз, после чего в блоке расширения отобразится список.

Можно перенести все фразы со страницы. Если хотите скопировать все, в том числе страницы со вложенными фразами, то лучше работать небольшими пачками, так как по мере наполнения списка расширение и браузер начнет тормозить.

Но, как вариант примитивной оптимизации, чтобы увидеть какие фразы и отдельные слова/синонимы описывают тематику или конкретную страницу, для сильно НЧ текстов с малым числом запросов можно.

Можно ли создать полностью автоматически

Максимально чисто и точно нет, но на определенный процент возможно. Например, используется групповой отчет Keys.so для выгрузки ключевых слов всех тематических конкурентов.

Затем экспортированные ключи разбиваются по группам в Keys.so в инструменте «Кластеризатор» (или другом SaaS решении с функцией кластеризации).

При таком подборе ключей всегда будет существенный недобор (не берутся запросы с Вордстата, подсказок Яндекса и баз). Автоматический группировщик 100% не доработает и оставит значимый остаток в отдельной папке, которые следует проанализировать руками.

Этапы создания запросного ядра сайта

Последовательность первых пяти пунктов может значительно меняться от типа и специфики проекта. Представлен самый простой вариант для классических статейников.

- Выгрузка запросов конкурентов и добавление в проект. Например, если сайт по тематике «кондиционеры», то у него явно есть мощные конкуренты ТОП’ы, которые уже имеют трафик и хорошую оптимизацию. А значит, они находятся в выдаче по ряду запросов (имеют видимость), которые нам и нужно получить. Делается это с помощью различных сервисов.

- Дополнение проекта ключами из баз (ы).

- Формирование базового списка ключевых слов – запросов масок и маркеров.

- Определение списка стоп-слов, дабы почистить мусорные запросы или сразу исключить на этапе парсинга.

- Парсинг Яндекс и Google по вводным словами, чтобы вытащить все словосочетания, в которые входит основа с первого этапа.

- Чистка запросов. Сюда входит парсинг по частотности, чтобы убрать нулевые запросы, чистка по стоп-словам для удаления неподходящих ключей под тип проекта. В итоге получается максимально чистый список запросов, нуждающийся в кластеризации.

- Разгруппировка. На первых четырех этапах мы получаем сплошной громадный список. Его надо разгруппировать (кластеризовать). На выходе получаются отдельные группы запросов, каждая из которых соответствует определенной теме (проблеме человека, желанию совершить конкретное действие). Каждая группа строго соответствует одной странице проекта. Примеры показывал выше.

Что такое кластеризация ядра

Под кластеризацией семантического ядра понимают распределение ключевых запросов по отдельным группам (кластерам). Задача кластеризации состоит в объединении идентичных по смыслу (интенту) запросов под одну веб-страницу из общего перечня фраз.

Существует автоматическая и ручная группировка запросов. Для автоматической нужны онлайн-сервисы или компьютерные программы. При ручной кластеризации объединение происходит после анализа выдачи и на основе смысловых критериев, то есть даже разные слова, если означают одно и то же, помещают в одну группу.

Ручная, в свою очередь, также выполняется во вспомогательных программах или сервисах, но фразы проверяются в ручном режиме.

| Сравнение методов кластеризации запросов | ||

| Достоинства | Недостатки | |

| Автоматическая |

|

|

| Ручная | Высочайшее качество за счет глубокой проработки. Условно бесплатно, если не потребуется покупать тот же Key Collector. |

|

Как собрать семантическое ядро для сайта: пошаговая инструкция

Сбор для инфопоратала намного легче и быстрее по времени (в то же время в разы объемнее), чем для коммерческого, можно и не пользоваться встроенными в KC инструментами по кластеризации. Даже на больших ядрах удается рассортировать запросы обычными фильтрами через поиск по общему перечню фраз.

Покажу разработку на одном из разделов давнего проекта, чтобы не тратить уйму времени на парсинг ключевых слов. Тем более, что все ядра для текущих сайтов составлены, и не хочется зря тратить деньги на прокси с капчей.

Что необходимо для составления

Для сбора семантического ядра по классической методике (наиболее эффективной, но рутинной) потребуются:

- Key Collector. Многие считают, что программа сама собирает семантику, но это лишь инструмент для удобной и быстрой работы с запросами, сбора параметров и обработки – то есть нужны вводные данные. Key Collector в десятки раз ускоряет и упрощает работу.

- Keys.so. Лучший сервис для онлайн выгрузки ключевых слов конкурентов. Пожалуй, самый популярный сервис, отчасти благодаря пиару от лидеров рынка SEO-продвижения. Можно напрямую не пользоваться, так как нужный нам тариф стоит недешево и покупать для создания одного ядра не очень выгодно. Обычно прошу кого-то или покупаю выгрузку конкурентов на Kwork.

- Букварикс (https://www.bukvarix.com/). Огромная база ключевых слов. Сейчас доступна в режиме онлайн, но стала платной (695р за подписку на месяц). Ранее приходилось скачивать базу в десктопной версии, объемом 110 Гб. Да еще и работа была не самой быстрой, иногда экспорт приходилось ждать по пол часа и более, если при выгрузке использовались минус-слова.

- Прокси-сервера. Покупаю тут целенаправленно для KC https://proxy.market/ (по промокоду khmelov скидка 5%). Ускоряют парсинг данных. Изначально KeyCollector работает в один поток с основным домашним IP-адресом провайдера, т.е. за единицу времени обрабатывает только один запрос. Если купить 10 прокси серверов, то программа будет собирать данные в 10 потоков – скорость работы увеличиться в 10 раз. На больших ядрах я иногда добавлял до 100 прокси-серверов, благодаря чему собирал миллионы фраз за несколько дней.

- Сервис распознавания капчи (https://anti-captcha.com/ru или https://rucaptcha.com/). При парсинге каждый прокси-сервер будет создавать запрос в Яндекс для сбора частотки или выгрузки фраз. Естественно, это «незаконно» (считается спамом), и Яндекс будет пытаться блокировать такие запросы капчей. Вводить руками капчу бессмысленно, поэтому пополняется баланс в одном из сервисов антикапчи, где и будет идти распознавание другими людьми.

Во сколько обойдется перечисленный набор?

- Key Collector – 2200 рублей на первую лицензию (на вторую 2-10 компьютеры 1700);

- выгрузку с key.so можно заказать на Бирже фриланса Kwork за 500р (или у меня за 350 р);

- за прокси придется отдать от 140р за сервер IPv4 на месяц, в зависимости от сервиса и самых серверов (индивидуальных, или групповых);

- букварикс – 695р на месяц (или бесплатно программой на ПК под Windows);

- распознавание капчи – все зависит от объема ядра. В последний раз на почти 2 млн ключей я потратил около 70 долларов на капчу;

- под каждый прокси покупается или создается лично отдельный аккаунт Яндекс.

Key Collector остается пожизненно со всеми последующими обновлениями и выпусками новых версий программы. В суммарные траты капчу не учитывал, но надо помнить о ней, так как расходов не избежать.

Есть варианты дорогие и дешевые. Бюджетные замедляют и усложняют проработку, с дорогими побыстрее и сильно проще, но и стоят значительно больше. Дорогие варианты годятся для больших объемов, если нужно в короткие сроки спарсить много запросов и данных. Например, можно парсить запросы не в Key Collector, не покупать прокси, а воспользоваться каким-то сервисом. Даже при миллионах ключей я обходился вышеперечисленным набором.

Важный нюанс по аккаунтам и прокси

Яндекс очень строго относится к парсингу, поэтому нужно иметь действительно качественные сервера и аккаунты. Если будете создавать самостоятельно, то обязательно нужно каждый акк регистрировать совместно с прокси. То есть, сначала настраиваете браузер для работы с конкретным сервером, а потом только регаете аккаунт на уникальный номер (можно арендовать онлайн).

Покупка чужих тоже работает, но нужно искать аккаунты с необходимыми данными, чтобы вы могли зайти в них, т. е. подтвердить по номеру или контрольному вопросу, иначе Key Collector не сможет авторизоваться.

Можно ли обойтись без прокси (неужели есть волшебная таблетка)

- Парсить получится через внешне сервисы, например, https://xmlriver.com/. В настройках KC следует вбить ключ и собирать данные в 10 потоков (максимум). Стоимость сбора 1000 фраз на среднем тарифе (3000 рублей) обойдется в 15 рублей. То есть, чтобы собрать и получить частотности, на 1 тыс. фраз придется отдать 30 рублей. Собирать расширенные частотности, не только базовую, напрямую в KC невозможно, поэтому придется получить данные во внешнем софте от сервиса, потом экспортировать результаты в файл и импортировать обратно в Коллектор – «ужсссс…».

- Идеальным с точки зрения скорости и удобности является сервис https://word-keeper.ru/. По факту, это онлайн версия KC, где можно собирать и группировать, а скорость парсинга в десятки/сотни раз выше, чем в любом решении. Парсит в глубину, то есть каждую собранную фразу прогоняет еще раз. А цена за 1000 фраз составляет 18,45 рублей на месячном тарифе за 3690 (дается 300 тыс. лимитов) – удастся получить 200 тыс. готовых фраз. Есть выгрузка не только в Excel, но и в полноценный проект KC, поэтому можно сразу частично поработать в онлайн-режиме, а потом перейти в Коллектор. Считаю, что это лучшее решение многих проблем со скоростью и экономией времени. С Word Keeper, для небольших проектов, KC я открываю только для того, чтобы хранить данные на компе и чуток дорабатывать, при необходимости. Как вижу по рынку, то довольно недооцененный инструмент и менее разрекламированный, в отличие от того же MOAB.

Вратце про MOAB Tools. Тоже собирает в глубину, но мне не зашел по одному простому параметру. Нельзя собрать отдельно частотность по маске. Вместе с этим обязательно нужно собрать базовые показы, из-за чего идет двойная переплата за съем частотности.

Обязателен ли Key Collector

Инструмент из рубрики «Must Have» каждого SEO специалиста. Поэтому, лучше обзавестись программой для семантического ядра, ну или использовать вышеописанный Word Keeper на платной основе.

Базовая настройка Key Collector для парсинга

Настройка заключается в подключении нужных, ускоряющих процесс парсинга функций. Key Collector адаптирован под все распространенные решения на рынке для работы с пользовательскими запросами. Поэтому, если вы имеете и пользуетесь какими-то платными сервисами, то можно избавиться от кучи Excel-таблиц. Все данные сразу можно выгружать в окно KC и там же обрабатывать, а потом сделать общий импорт в табличный файл.

В нашем случае необходимо связать программу с сервисом антикапчи, прокси и аккаунтами Яндекс.

- Зайдите в настройки через меню «Файл» или иконку шестеренки в панели быстрого доступа.

- Настройка антикапчу, выбрав сервис и указав токен (берется с сайта в личном кабинете).

- Добавьте прокси сервера в меню «Сеть». В каком формате нужно добавлять, подскажет информация в окне после нажатия на кнопку «+». Также появится опция проверки прокси, которой непременно нужно воспользоваться.

- Пропишите аккаунты совместно с серверами и запустите проверку.

- Выставьте настройки парсинга Yandex.Wordstat. Нужно задать количество потоков (равно количству прокси и аккам), не использовать основной IP и на первых этапах лучше делать сбор в безопасном режиме, а по мере прогрева акков можно переключиться на «Нормальный» или даже «Быстрый».

- Такие же параметры задайте для Yandex.Direct.

- Аналогичная настройка для раздела «Подсказки».

- Обзятаельно сохраните настройки – кнопка «Сохранить в правом нижнем углу».

Этого достаточно, чтобы запустить сбор. Есть и другие неплохие полезные настройки, но пока трогать не будем.

Какую тематику выбрал

Для примера остановлюсь на нише лакокрасочных материалов (ЛКМ).

Начинаю смотреть на все элементы главных страниц конкурентов, особенно, на категории и подкатегории. Вижу, что сайты разделены на типы ЛКМ – клей, краска, эмаль, герметик, лак, мастика, грунтовка, шпаклевка. Причем на сайтах рассматриваются как материалы, так и работы – «как покрасить», «как приклеить», «грунтовать» и так далее.

Из описанного выше уже получаю список вводных слов, по которым можно приступить к парсингу.

Сбор входных слов

Понятно, что «Клей» является самым общим, поэтому начинаем от него отталкиваться.

Установите и активируйте в браузере расширение через встроенный магазин – Yandex Wordstat Assistant.

Вбиваю в поле Wordstat «Клей» и смотрю, что покажет правая и левая колонка. Нажимая «+», добавляю все подходящее в блок Wordstat-ассистента.

Пока не трогал марки клеев (Loctite и т. д.), но их также нужно брать – опустил для скорости рассмотрения процесса.

Дополнительно переходите по всем фразам, чтобы еще найти какое-то формы.

Когда Wordstat перестанет давать новые варианты, начинаем мозговой штурм и поиск информации о словоформах в сети.

Что получилось:

клей;

клеить;

склеить;

приклеить;

клеящий;

клеят;

наклеить;

клеевой;

отклеить;

наклеенный;

оклеить;

склеивание;

наклеивание;

приклеивание;

оклеивание;

поклеить;

склейка;

поклейка;

заклеить;

заклеивание;

отклеился;

отклеивается.

Используем бесплатный комбинатор https://www.bukvarix.com/combiner/.

В первую колонку вставляем собранный список, а во вторую информационные маркеры со знаком «+» перед словом.

Чтобы уж точно нивелировать все нюансы Wordstat, рекомендую добавить и предлоги.

⇒ Посмотреть инфомаркеры и предлоги

Инструмент сделал пересечение между всему словами и дал 550 фраз. Можете скопировать фразы в буфер или экспортировать в txt-документ.

Дополнительно для повышения качества можно скомбинировать маски с маркерами, то есть дополнительными словами, которые более точно дают понять, чего желает пользователь.

Маркеры следует смотреть в Wordstat по однословинку, а также через заголовки H1 и Title конкурентов.

Например:

плиточный;

плитки;

потолок;

плинтус;

линолеум;

багет;

пластик;

двухкомпонентный

эпоксидный;

убрать;

удалить;

удаление;

отстирать;

флизелиновых обоев;

и куча других.

Формируете маркеры, а потом комбинируете с основой, что даст сотни или даже тысячи вариантов, которые однозначно выпарсят весь Wordstat до корней.

Добавление баз в проект KC

На первом этапе чаще добавляют внешние источники, а не Wordstat, чтобы значительно сократить и ускорить парсинг. Есть замечательная опция – «Пропускать фразы, которые уже есть в любой группе». Так, если ключевой запрос уже есть в проекте, то при парсинге он будет пропущен и не добавится в семантическое ядро.

На больших ядрах такая последовательность сбора не только увеличивает скорость, но и может сильно сэкономить бюджет, так как при использовании платных инструментов деньги списываются за объем.

- В Keys.so заходите в раздел «Групповой отчет».

- Вставляете все сайты конкурентов.

- Дожидаетесь анализа и выгружаете все ключевики в Excel.

- В Bukvarix также можно провести анализ по конкурентам, но лучше выгрузку формировать именно по маркерным запросам. Причем сразу можно задать минус-слова, чтобы не пихать в проект лишние фразы (купить, цена, города и т. д.). Для загрузки списка ключевых слов нужно перейти в раздел верхнего меню «Подбор слов»-«Расширенный».

Для информационки можно немного пренебречь размером семантики и удалить микро-НЧ запросы (например, до 5-ти или даже 10-ти точных показов в месяц). В обоих сервисах есть возможно выставить фильтр ограничения по частотности.

Открываем Key Collector, создаем отдельные группы под каждый источник и закидываем фразы.

При загрузке ключей во второй, третий и так далее источнике обязательно активируйте режим поиска дублей.

Можно и в общую поместить, но лучше изначально разделять, и дополнительно создать общую группу, куда вытянется более-менее почищенное ядро к последующей группировке.

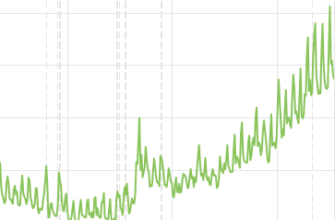

Время добавления сильно зависит от количества. Есть много пересечений между базами, поэтому конечное количество будет значительно меньше, чем суммарное. Обратите внимание на скриншот добавления Keys.so. Итого конкуренты видны по 49488 ключам, но после импорта в группе оказалось 18535, потому как в базе Bukvarix большинство присутствовало.

Огромный объем из Буквариска связан с тем, что при выгрузке базы не использовал стоп-слова и не ограничивал частотность.

На 11-летнем ноутбуке с SSD импорт почти 800 тысяч ключевых фраз занял около 3 минут.

Первый прогон фраз

Запускаем парсинг по скомбинированному списку и однословникам одновременно с левой колонки Wordstat в отдельную группу.

Не забываем ставить галочку, чтобы не плодить дубли и не увеличивать размер проекта.

В зависимости от количества потоков и настроек программы (задержек) может уйти немало времени. Нужно дождаться завершения, и желательно погладывать в журнал время от времени, так как возможны ошибки и преждевременная остановка всего парсинга или отдельного потока из-за сильного капчевания аккаунта и, в последствии, полного отключения.

После окончания процесса в эту же группу (или отдельную) собираем поисковые подсказки Яндекс по вводному списку.

Результат первого парсинга семантического ядра – 37998 фраз.

Повторный парсинг в глубину

Key Collector в Wordstat’е по каждому слову будет проходить 41 страницу и получит максимум 2050 результатов, что может сильно ограничить количество полезных фраз, особенно если вводный запрос сильно частотный или очень общий, как в моем примере («клей»).

Чтобы добрать все остальное, применяется повторная итерация парсинга первого списка, но уже более-менее почищенного.

То есть, копируются все собранные ключевики, которых вполне вероятно окажется несколько или десятки тыс., и по ним еще раз запускается сбор левой колонки Wordstat.

Как правило, двух итераций хватает, но в идеале парсить до тех пор, пока в Key Collector’е не перестанут появляться новые ключи.

Чистка ядра

Под чисткой подразумевается удаление мусора – нулевых и нецелевых фраз. Значит, снова придется парсить, поэтому для сокращения времени лучше сперва убрать побольше мусора.

В моем случае к мусору относятся фразы со словами «купить», «цена», «отзывы» (не всегда), топонимы (географический признак, города, регионы, страны, области и т. д.), а также все, что не относится ни к одной нормальной тематике (взрослые запросы и имена известных людей – Малышева и другие).

Например, может быть фраза «какой робот пылесос лучше купить для большого дома» — явно информационная.

Нужно применять комбинированный фильтр, чтобы оставить ключевые фразы с обеими словами.

В этом случае в таблице отобразятся только фразы, которые включают «купить», но не содержат любую форму слова «какой» (каким, какого, какому и т. д.), так как указана часть слова «как».

Избавляетесь от массы ненужного через функцию «Минус-слова».

Чтобы в дальнейшем эти же фразы не добавлялись по новой, полностью с проекта не удаляйте, а помещайте в корзину.

Дальше запускаете парсинг точных частотностей через Яндекс Директ.

Удаляете все значение с нулями или обрезаете до 5-10, если тема информационная, а запросов сотни тысяч. Так уберете много «слабого» и облегчите работу при группировке. Задаете фильтр по точной частоте, указываете параметры, применяете фильтр, и переносите в корзину.

Так как во внешних базах всегда есть неявные дубли (одинаковые фразы с перестановкой слов), то следует удалить некорректные формы, которые вообще не запрашивают, или оставить только самые частотные, так как не всегда только одна форма будет популярной.

Определить частотность с учетом порядка слов позволяет сбор по маске ([!QUERY]).

Если не будет проблемой парсить в десятки или сотни потоков, можно не заморачиваться с функционалом обнаружения неявных дублей, а глобально вытащить частотности по маске, затем снести нули в корзину. Но для ускорения и облегчения, лучше найти дубли в семантическом ядре и обработать конкретно их.

После анализа Key Collector 4 создаст новую вкладку «Найденные дубли».

Алгоритм дельнейшей работы:

- Отметьте все дубли.

- Примените изменения, чтобы отметки перенеслись в основную группу.

- Закройте результаты.

- Отфильтруйте колонку отметок, чтобы отображались только отмеченные ключевые фразы.

- Соберите частоты лупой по маске.

- Перенесите нулевые ключевики в корзину.

О чем и говорил – абсолютно идентичные фразы с перестановкой могут иметь большие частотности показов, поэтому в некоторых группах можно кое-что да оставлять.

Описан лишь один общий вариант работы с дублями в ядре, поэтому не следует профессионалам писать, что я кардинально неправильно действую.

Сделана основная чистка, осталось лишь пройтись глазами по ключам и выделить те слова, которые не являются целевыми. Можно делать как полностью вручную, так и воспользоваться опцией «Анализ групп».

Просматриваете сгруппированный по словам список и выделяете те слова, которые 100% не нужны для семантического ядра. Для примера сразу обнаружил слово «ногти», с которым аж 299 фраз.

Так проходитесь по всему списку и подчищаете. Но желательно разворачивать списки, так как не всегда там только ненужные фразы.

Например, со словом «Бумага» в моем ядре содержится как мусор, так и полезное. Например, мусор – подделки, полезное – чем клеить бумагу к пластику.

Таким образом достигаете максимальной чистоты ядра и переходите к кластеризации.

Если ядро слишком большое, то какая-то часть мусора допускается, так как его можно убрать уже в процессе группировки, удалив из готового кластера, что иногда даже намного легче.

Кластеризация

Два простых пути, которым можно следовать:

- Пользоваться полем для фильтрации по словам, вводя маркеры и перенося все фразы в новые группы, а уже потом догруппировывать и подчищать при необходимости. Например, я знаю, что есть запросы со словом «плиточный, плитка». Логично, что пользователю необходима информация о плиточных клеях и процессах по поклейке плитки. Вписываю в поле слово «плит», чтобы охватить все словоформы, выделяю найденные фразы в ядре и переношу в новую группу, называя, например, «плитка». Далее идет группировка внутри этой группы, руководствуясь смыслом и выдачей.

- Автоматический поиск маркеров через «Анализ групп» (показал выше на примере чистки). Например, из общей массы четко выделяется слово «слайм» – отмечаю фразы и переношу в группу «слайм».Там выделяются слова «пены», «тетраборат» — создаю подгруппы. Так нужно делать, пока все запросы не будут распределены по группам.

В каждом варианте параллельно нужно открывать Яндекс, вбивать ключевую фразу и проверять выдачу. Таким образом сможем определить, как делают конкуренты – объединяют или разделяют.

Например, фраза «слайм из тетрабората натрия без клея», которая вводит в заблуждение. В какую группу (статью) определить? В статью про слаймы без клея или про слайм из тетрабората? Вбиваем в поиск и смотрим – если ранжируются обе статьи по запросу, то распределяете по своему смотрению, а лучше оставить в группе, которой больше в выдаче.

Еще пример: фраза «как клеить обои» и «чем клеить обои». Передают разные смыслы – в одном случае человек хочет увидеть процесс поклейки, а во втором узнать, какое клеящее средство использовать. Но что говорит выдача?

Как видите, по запросу «чем клеить» выдаются статьи про поклейку, а не про выбор клея, хотя парочка вариантов и таких имеется. Тут также делаете выбор сами – можно либо объединить, что будет правильно, либо отнести запросы со словом «чем» в группу про выбор клея для обоев (какой лучше и т. д.).

И снова пример (да остановите…): фразы «клей для плитки» и «клей для плитки универсальный». Не совсем понятно, универсальность подходит для отдельной статьи, или рассматривается в рамках общей про клеи. Выдача говорит, что статья общая про обзор (рейтинг) лучших клеев.

Последний пример: фраза «клей для плитки влагостойкий». Выдача показывает три варианта страниц по запросам «в ванную» (3 шт, зеленый), «для бассейна» (1, красный), общая страница (3, синий) и конкретно под «влагостойкий» (1, желтый).

Если идти чисто по выдаче, то запросы со словом «влагостойкий» нужно отнести в группу под статью по выбору клея для ванной или общую. И это логично, ведь в 99% случаев самым влажным помещением, где монтируется плитка, является ванная комната.

Резюме: группировка начинается с выделения общих интентов – плитка, обои, плинтус, дерево, пластик, металл и т. д. Затем каждая группа разбивается дополнительно – тот же пример для плитки (ванная, на пол и т. д.). Если есть какие-то уточняющие слова, делают поиск в Яндексе и проверяют, по какой статье запрос ранжируется.

Дополнение: в анализе групп есть вариант типа группировки «по составу фраз», которых также есть несколько. Если простыми словами и вкратце, то алгоритм будет давать не отдельные слова после вычислений ядра, а группы разобьются по пересечениям. Количество пересечений определяется выставленной силой группировки. Инструмент крутой, но нужно научиться им пользоваться и подбирать наиболее подходящие настройки для конкретного ядра.

К сожалению, описать кластеризацию полностью в одной статье невозможно. Как говорил в начале статьи, может получиться целая книга. Но, надеюсь, что общая методика более-менее понятна.

Пару слов о планировщике

В KC есть планировщик задач, в котором можно последовательно дать задание для автоматизации сбора.

Например, легко можно сделать так, чтобы сначала выполнился сбор Wordstat, потом подсказок, потом подсчет частотностей, потом удаление нулей и так далее. Очень помогает, когда нужно куда-то отлучиться, уехать, или парсинг небольшого ядра планируется на ночь, чтобы при завершении одной задачи началась следующая. Небольшие стандартные задачи автоматизирует на раз, но для сильных многоходовых процессов придется задать немалое количество действий в очередь в планировщике.

Что на выходе

Гляньте пример (урезанный, Excel), в котором буквально за полчаса сделал 10 групп и уже начал создавать ТЗ для копирайтеров.

В ядре есть небольшие огрехи по лишним запросам (цена и чуть нетематичного), так как особо не подчищал, к тому же семантика для себя, а не на заказ.

Подбор ядра онлайн на основе конкурентов

Очень актуальная методика для работы с уже готовыми страницами, чтобы доточить их на основе конкурентов. Берутся, например, ТОП-5 целевых страниц конкурирующих ресурсов, выгружаются в сервисе Keys.so. Смотрите на ключи, по которыми конкуренты добились верхушки выдачи, и дорабатываете свой веб-документ.

Способ не самый лучший, но для увеличения трафика, если исходные показатели желают лучшего, вполне сойдет. В идеале, прорабатывать ядро в полном объеме.

Также очень крутой подход, когда следует подобрать ключевые слова для статьи информационного раздела в коммерции или полноценного контентного сайта. Действия такие же – смотрим на самые популярные страницы конкурентов (по значению видимости), экспортируем видимые ключи в Эксель, создаем ТЗ и отправляем копирайтеру на написание.

Так как проработка постраничная/постатейная, то проектирования сайта с нуля не получится, что особенно важно для коммерции. Чтобы в будущем иметь возможность изменить структуру без последствий для SEO, нужно сразу задать правильные настройки на сайте. Например, URL-адрес сформировать без цепочки категорий и подкатегорий, а вида «домен/адрес статьи», чтобы при создании нового раздела или перемещении статьи в другой существующий, URL не поменялся.

Кроме постраничной работы, можно полностью обойтись без Wordstat и выгрузить сразу всю семантику конкурентов в единый файл, собрать данные через KC и сгруппировать. Таким образом получим аналогичное ядро, только без данных Яндекс Wordstat, что значительно сужает охват. Но для информационки подобная технология показывает достойные результаты – лично использую на возрастных проектах, где ранее сделанная семантика за 2-3 года претерпела существенных изменений.

Разница в составлении между типами сайтов

Шаги по сбору не отличаются, сначала набрасываются вводные (входные) слова, затем парсятся, чистятся и группируются, но с некоторыми поправками:

- минус-слова совершенно разные – то, что оставляется в информационке, в коммерции исключается;

- во многих случаях оставляются нулевые запросы, т. к. из-за фактора сезонности в определенный период года они могут иметь частотность, а значит, в оптимизации также участвуют;

- чтобы не собирать лишнее, на этапе согласования с заказчиком следует оговаривать нюансы деятельности, предоставляя ему предполагаемую будущую структуру проекта и ядра – владелец должен изучить наброски и исключить то, чем не занимается.

Ответы на частые вопросы по семантике (FAQ)

Личное обучение составлению семантического ядра

Провожу индивидуальное обучение, а не групповое, и не в записи, что очень удобно и наиболее результативно конкретно в вашем случае. Обучение представляет собой разговорное общение в Skype или Telegram с удаленным доступом к вашему компу, где я буду все показывать, а вы записывать экран любым способом.

Все объяснения вопроса включают не только рассмотрение конкретной ниши, но и углубление в смежные вопросы – позволяют в будущем взяться за другую тему с минимальными сложностями.

Суммарно около 4-5 основных продолжительных созвонов по 1,5-3 часа + несколько промежуточных по возникающим вопросам. По итогу должно быть собрано хотя бы несколько групп или даже разделов, что прямо зависит от сложности направления и уделенного личного времени. Текстовая поддержка после основных созвонов в течение месяца с возможностью продления на платной основе в виде консультаций по переписке (недельные и месячные тарифы).

Стоимость 20000 рублей.

Заказать семантику: дорого, но качественно

Если не хотите вникать в тему, можете купить семантику у меня. Сделаю все максимально, как только умею.

Стоимость готового ключа 6,5 рублей.

Минимальный заказ 25000 рублей, после отработки можно продолжить такими же пачками. Составляются ядра только на русском языке.

Обращайтесь в Telegram @khmelov1 или пишите в комментариях ниже.

Что необходимо указать в обращении:

- направление (инфо или коммерция – уточнить, магазин или сайт услуг);

- точную тематику (кондиционеры, люстры, шторы…);

- сбросить ссылку на сайт (если создан) и конкурентов (если анализировали);

- личные пожелания и предпочтения, которые могу учесть при работе, но не гарантирую.

После вашего сообщения отвечу (ориентируйтесь на 2-3 суток) и отправлю принцип нашего дальнейшего взаимодействия, уточняющие вопросы, чтобы точно узнать нюансы вашего бизнеса/сайта, проверю и дам окончательный ответ. Учитывайте, что работы начинаются в течении недели после согласования деталей.

Обычно работаю с информационными ядрами, но нередко берусь и за коммерческие, если нет сложной специфики, в которой необходимо экспертное понимание тематики.

Для информационки бонусом формируются 15 очень подробных технических заданий для копирайтера стоимостью 300 р каждое (см. страницу услуг) – дают мощный выхлоп даже в популярных темах. Собираются тщательно комбинацией автоматического и ручного режима.

Заключение

20 страниц в MS Word, почти 7000 слов, 42000 символов б/п – результаты многодневного труда, который, надеюсь, не останется без внимания и отклика. Скорее всего, больших по количеству знаков статей на блоге не предвидится.

Возникли вопросы или нашли неточности/ошибки – рад видеть в комментариях ⇓.

Используемые источники при написании:

— свой мозг.

Помню Вашу прошлую статью про семантическое ядро, которая также была очень подробной и большой. Тогда это было лучшее, что удалось найти в интернете. В этот раз также не разочарован и почерпнул много нового. Особенно порадовало, что убрано много лишнего, те же функции расширения через Rooke и все подобное в этом же роде.

Да, объяснять семантику просто текстом лишь бы опубликовать статью, как это сделано в ТОП’е, не вижу смысла, ведь такие материалы не решают проблему. И, да, убраные бесполезные моменты, только минимальный набор, обеспечивающий практически максимальное покрытие.